Um tropeço na Austrália que dinamitou a confiança na IA

Há dois meses um episódio na Austrália disparou alarmes sobre os riscos da aplicação de inteligência artificial generativa (IA) sem supervisão humana adequada. A Deloitte Australia havia sido contratada em dezembro de 2024 pelo Departamento de Emprego e Relações de Trabalho (DEWR) para avaliar um sistema automatizado de controle de bem-estar. Foi uma comissão sensível, realizada após o escândalo "Robodebt" (encargos indevidos aos beneficiários sociais) que tinham alertado o país, o que aumentou a importância do relatório resultante. O produto final foi um relatório de 237 páginas entregue em julho de 2025, que inicialmente não revelou o uso de IA em sua preparação.

O relatório parecia abrangente e técnico, até o final de agosto de 2025, quando um pesquisador jurídico da Universidade de Sydney, Dr. Chris Rudge, descobriu algo perturbador ao lê-lo. Uma das notas de rodapé citava a sua colega, a professora Lisa Burton Crawford, atribuindo-lhe um livro inexistente sobre direito constitucional – uma obra que simplesmente não poderia existir na sua área de especialização. Segundo Rudge, Eu imediatamente soube que tinha sido alucinado pela IA ou que era o segredo mais bem guardado do mundo, porque eu nunca tinha ouvido falar do livro e parecia absurdo . Esta anomalia inicial levou a uma análise mais profunda do documento, revelando aproximadamente 20 bugs fabricados no total. Entre eles estavam Falsas referências académicas (livros e artigos confecionados atribuídos a verdadeiros peritos) e Citações incorretas , como um processo judicial citado com referências que não correspondiam e uma citação falsa atribuída a um juiz federal (nome com erros ortográficos e com palavras que ela nunca falou). Ainda mais preocupante, o relatório tratou desse caso ( Amato vs Commonwealth ) como se tivesse havido um julgamento firme, quando na verdade terminou em um acordo de consentimento – um erro que denotou Equívoco jurídico básico pelos autores do documento.

Ciente da gravidade, Rudge decidiu alertar a imprensa. Uma coisa é citar incorretamente académicos ou imputar obras inexistentes, outra coisa é citar incorretamente – e, portanto, deturpar – a lei num relatório governamental , explicou, sublinhando que desinformar o Executivo sobre jurisprudência era um assunto muito sério. Suas descobertas foram publicadas pela Australian Financial Review no final de agosto, provocando perguntas desconfortáveis sobre como um dos "Quatro grandes" da consultoria conseguiu entregar um relatório com erros que um calouro Eu saberia evitar.

Correções apressadas, reembolso parcial e lições dolorosas

A resposta da Deloitte não tardou, embora tenha tentado passar despercebida. Em 26 de setembro de 2025, a empresa substituiu discretamente o relatório original no site oficial por uma versão revisada. Nesta atualização, removeram mais de uma dezena de referências fictícias e corrigiram citações judiciais falsas atribuídas ao juiz federal. Também suprimiram menções a livros inexistentes e, pela primeira vez , incluiu uma nota explicativa indicando que, na preparação do documento, uma cadeia de ferramentas baseada no Azure OpenAI (GPT-4o) foi usada . Esta confissão de que a IA fazia parte do processo expôs a falta de transparência inicial. Na nova introdução, a Deloitte garantiu que As atualizações efetuadas não afetam nem afetam de forma alguma o conteúdo substantivo, as conclusões e as recomendações do relatório , reconhecendo que eles usaram GPT-4 durante o rascunho inicial, mas alegando que um posterior "Revisão humana refinou o conteúdo" . A empresa sustentou, assim, que as conclusões permaneciam plenamente válidas.

No entanto, a forma como a Deloitte corrigiu o relatório levantou novas dúvidas sobre o rigor do processo. Quando os jornalistas pediram exemplos das referências alteradas, verificou-se que As novas fontes também não apoiaram as alegações originais , sugerindo que a empresa tentou corrigir os erros pedindo novamente à IA referências "reais" para as mesmas alegações. Por outras palavras, o Rastreabilidade Continuava a ser escasso: as alegações do relatório não estavam ancoradas em provas, mas em construções feitas à máquina sem uma base documental sólida.

O incidente causou danos financeiros e reputacionais em outubro de 2025. Para contê-lo, a Deloitte Austrália concordou com o governo em Reembolso parcial do contrato . Inicialmente, propôs-se a devolução do pagamento final em dívida e, em 20 de outubro, confirmou-se o montante exato: A$97.000 (cerca de US$63.000), aproximadamente 22% do total contratado . Embora a Deloitte tenha continuado a afirmar que O conteúdo da revisão mantém-se e que não houve alterações nas recomendações, o gesto de reembolso implicou uma admissão tácita de responsabilidade. Do lado do governo, foi afirmado que "Algumas notas de rodapé e referências estavam incorretas" no relatório, mas que o conteúdo principal ainda era válido – uma forma diplomática de reconhecer erros sem inflamar a questão. Ainda assim, o episódio levou a DEWR a anunciar que futuros contratos de consultoria incluirão cláusulas mais rigorosas sobre o uso de IA , para evitar situações semelhantes. Na frente política, a senadora Barbara Pocock, do Partido Verde, exigiu que a Deloitte Reembolso de 100% dos 440.000 AUD, lamentando que a firma tivesse IA mal utilizada: citou mal um juiz, usou referências inexistentes. Os tipos de coisas para as quais um calouro da faculdade estaria em sérios problemas . Vozes críticas comparando um consultor de elite a um estudante novato refletiram o golpe reputacional. Acadêmicos afetados, como o professor Burton Crawford, também estavam preocupados em ver pesquisas falsamente atribuídas a seus nomes.

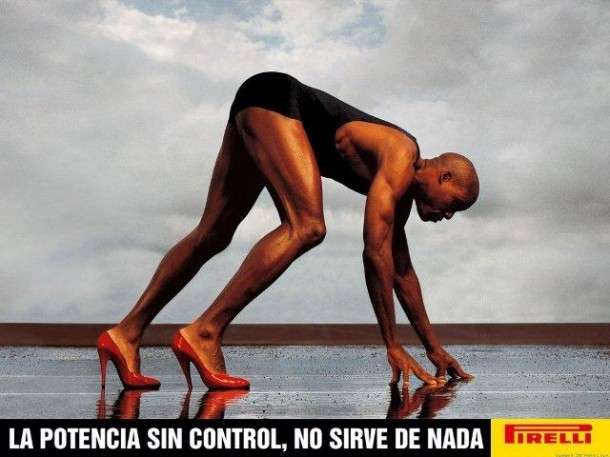

O paradoxo final veio algumas semanas depois: o No mês em que a Deloitte estava enfrentando esse tropeço com IA, anunciou com grande alarde a implantação maciça de outra ferramenta de IA (Claude, da Anthropic) para seus 500.000 funcionários globalmente . Esta contradição – reconhecer falhas graves e, simultaneamente, duplicar a IA – captou perfeitamente o momento em que vivemos. A adoção da inteligência artificial pelas empresas está avançando a um ritmo vertiginoso, às vezes mais rápido do que as salvaguardas adequadas estão em vigor , impulsionado pela pressão competitiva e pelo medo de ficar para trás. O caso Deloitte, longe de ser um escândalo isolado para usufruto público, deve ser entendido como Um sinal de alerta precoce sobre os riscos sistémicos da utilização da IA sem controlos adequados. Um erro de centenas de milhares de dólares – e os danos reputacionais associados – poderia ter sido foram completamente evitados com a abordagem e as ferramentas corretas . Abaixo, tiramos as lições estratégicas deste incidente e exploramos soluções concretas para que a história não se repita.

O risco sistémico de adotar IA sem garantias

O que aconteceu na Austrália repercutiu globalmente porque expõe um risco latente: a adoção de IA generativa sem as devidas salvaguardas não é apenas um problema para uma empresa de consultoria, mas um perigo sistémico . Está cada vez mais claro que, em setores como consultoria estratégica, formulação de políticas públicas ou qualquer área regulamentada, confiar em modelos de IA sem controle humano robusto pode levar a erros catastróficos e decisões mal informadas.

Por que exatamente ocorreu o "tropeço" da Deloitte? As causas são tecnológicas e organizacionais. A nível técnico, o relatório imperfeito ilustra o fenómeno da Alucinações por IA : Os modelos de linguagem atuais, por mais avançados que sejam, às vezes geram conteúdo que parece plausível, mas é completamente inventado. Isto acontece porque um grande modelo generativo (LLM) não é uma máquina da verdade, mas uma máquina de calcular probabilidades ; Ele prevê palavras com base em padrões estatísticos de seu treinamento, não em uma compreensão comprovada da realidade. Você pode escrever frases muito convincentes – até mesmo citações e referências com formatação acadêmica impecável – mas ele não tem conhecimento da veracidade desses conteúdos. Como explicam os especialistas, estes sistemas Podem criar conteúdos plausíveis sem fontes reais ou bases factuais . E, a menos que sejam complementados por mecanismos específicos, não verificam se as fontes mencionadas existem realmente . Na verdade, quanto mais eles leem textos acadêmicos reais, mais eles são capazes de imitar seu estilo e Fabricar citações credíveis , que é uma perigosa espada de dois gumes. No relatório da Deloitte, a IA simplesmente gerou referências no formato esperado porque Aprendido de milhares de relatos autênticos, sem distinguir entre o real e o fictício.

A nível organizacional, o caso reflete deficiências nos processos de controlo de qualidade e na cultura de adoção da IA. As grandes empresas de consultoria operam num mercado muito competitivo, com pressão para entregar mais rápido e a custos mais baixos . A tentação de recorrer a ferramentas como o ChatGPT ou similares para acelerar a escrita de relatórios extensos é compreensível. A Deloitte, ao envolver o GPT-4 na fase de rascunho, provavelmente estava procurando essas eficiências. O problema é que, ao focar na velocidade e conveniência, ignorou as verificações necessárias para garantir a precisão . Os erros básicos detetados – como atribuir a um juiz frases que ele nunca disse – indicam que o A revisão humana foi insuficiente ou não muito sénior . Mesmo após a correção, o Falta de rastreabilidade : nem mesmo os próprios consultores poderiam comprovar certas afirmações com fontes reais, porque originalmente não havia nenhum . Além disso, a empresa falhou em comunicar o uso de IA ao cliente inicialmente , uma decisão que privou o DEWR da oportunidade de exigir garantias adicionais ou de analisar o resultado de forma mais cuidadosa desde o início. Esta falta de comunicação violou as boas práticas e minou a confiança quando tudo veio à tona.

O risco sistémico, portanto, é que um número crescente de organizações incorpora IA generativa em tarefas críticas sem adaptar seus processos internos . Se uma empresa do calibre da Deloitte caiu neste erro, outras podem estar a fazê-lo também. Na verdade, já vimos casos semelhantes em diferentes áreas: em maio de 2023, dois advogados em Nova York foram sancionados judicialmente depois de apresentarem um documento legal cheio de citações de casos Inexistente criado por ChatGPT. No sector financeiro, este incidente da Deloitte é recordado como um Serviço de despertar que salienta que a IA não é reveladora da verdade; É uma ferramenta projetada para dar respostas que se encaixam em suas perguntas. Em outras palavras, a máquina dar-lhe-á alguma resposta –coerente na forma– a qualquer pergunta, mas não garante que seja correta em substância. Se os profissionais se esquecerem disso e depositar confiança cega na suposta inteligência da IA , as consequências podem ser graves. A narrativa constante de como a IA é "inteligente" pode levar-nos a confiar excessivamente nele, mesmo inconscientemente, e depender mais do que deveria .

Os sectores público e regulamentado enfrentam um risco acrescido: Erosão da confiança . No caso australiano, o relatório falhado dizia respeito a um Sistema automatizado de segurança social , já delicada após o escândalo anterior. Um relatório com citações jurídicas fabricadas poderia ter levado a políticas públicas mal calibradas ou a manter falhas em um sistema que penaliza cidadãos vulneráveis. Falhas deste tipo podem desinformar decisões que afetam milhões de pessoas e minar a confiança do público em sistemas governamentais automatizados . Quando os cidadãos descobrem que um relatório do governo tem erros "iniciantes" gerados pela IA, o dano transcende a empresa de consultoria: semeiam-se dúvidas sobre a qualidade do processo de formulação de políticas em geral e sobre a confiabilidade da tecnologia usada pelas instituições.

Felizmente, este episódio está também a gerar interessantes debates e medidas corretivas. O governo australiano, como vimos, anunciou cláusulas contratuais específicas para futuros trabalhos de consultoria envolvendo IA. E, a nível internacional, já estão delineadas Melhores práticas para evitar outro Deloitte-gate . Vários peritos e agências propõem, nomeadamente, as seguintes medidas concretas:

- Cláusulas rigorosas sobre o uso de IA em contratos : Os clientes devem estipular claramente quando e como a IA pode ser usada numa comissão, exigindo total transparência e certificações de revisão humana antes da entrega.

- Auditoria e rastreabilidade da fonte : cada declaração contida num relatório deve poder ser rastreado até à sua origem com Fontes verificáveis por humanos Qualificado. Trata-se de manter registos da Prompts e saídas de IA para auditoria.

- Quadros regulamentares transversais : prevê-se que os governos e as associações profissionais criem orientações sobre a utilização da IA nos serviços profissionais (consultoria, auditoria, jurídico, etc.), para homogeneizar padrões de qualidade e responsabilidade a nível internacional.

- Treinamento de IA para Funcionários : as equipas humanas devem formação em literacia em IA , sendo capaz de detetar alucinações ou referências implausíveis e compreender as limitações do modelo. A IA não pode ser deixada nas mãos de utilizadores não treinados.

- Gestão de riscos éticos : em Alto risco (ordem pública, previdência social, regulamentar, legal), deve ser aplicada salvaguardas adicionais quando a IA está envolvida , tais como inspeções independentes, dupla verificação por peritos ou ensaios-piloto antes de as conclusões serem implementadas.

A implementação destas medidas exige mudanças importantes na forma como trabalhamos, mas são cada vez mais necessárias. Em essência, todos eles apontam para uma ideia central: Manter o ser humano "informado" , controlando e validando o que a IA propõe. Não se trata de abrandar a inovação, mas de a integrar de forma responsável. E é precisamente aqui que se torna relevante uma abordagem que nós da Proportione temos vindo a desenvolver em projetos com clientes e que também aplicamos em ambientes de formação: a Modelo 20–60–20 de colaboração humana–IA–humana . Vamos dar uma olhada no que é e por que ela pode ser a chave para alavancar a IA sem comprometer a qualidade ou a ética.

O modelo 20–60–20: Colaboração humana–IA–humana com rigor e rastreabilidade

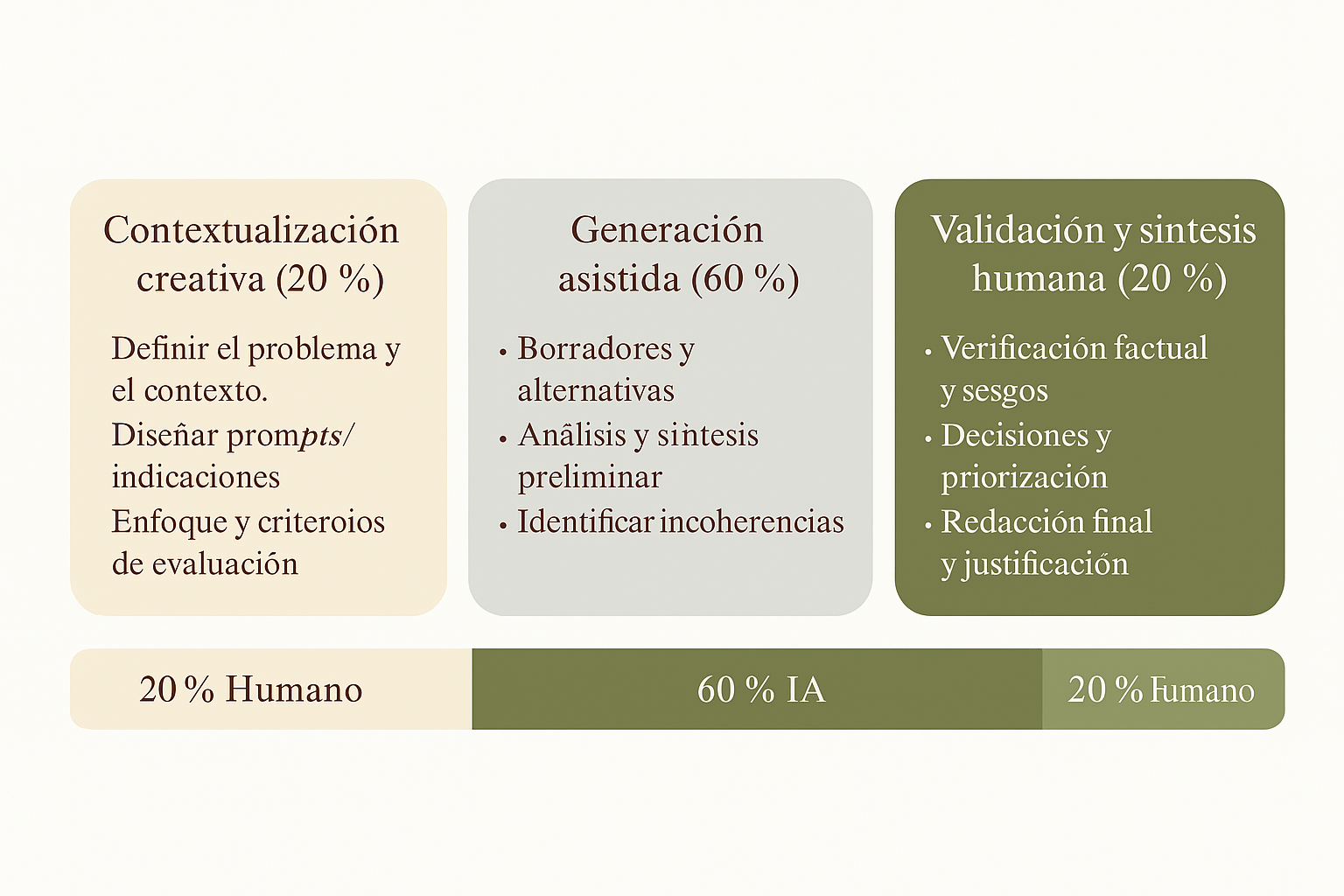

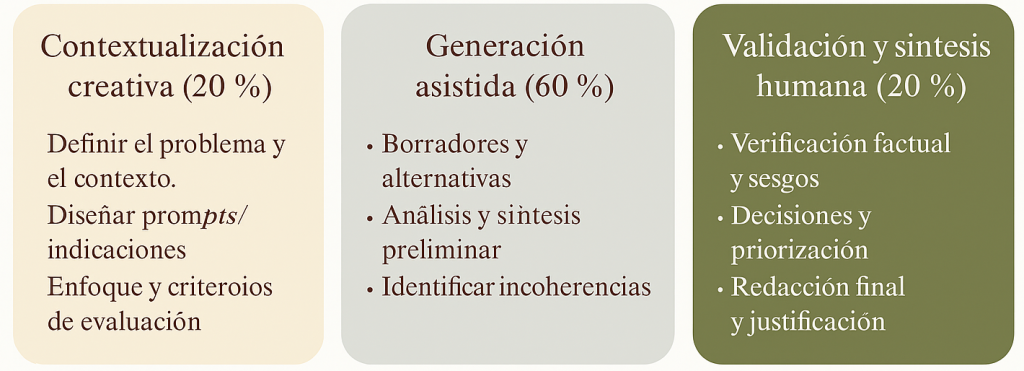

Na Proportione concebemos o Modelo "20–60–20" como resposta aos desafios que mostrámos. Este modelo, formulado por Javier Cuervo , divide qualquer tarefa intelectual assistida por IA em Três fases com percentagens indicativas de contribuição :

- Contextualização inicial de 20% e design humano : No início, a pessoa define o problema, o contexto, os objetivos e os objetivos do projeto. Critérios de qualidade isso é esperado. É uma fase de Enquadramento crítico : Dados confiáveis são coletados, fontes de referência relevantes são selecionadas e instruções claras para IA são escritas. Em termos simples, aqui o humano define o rumo e estabelece os limites.

- 60% de geração assistida por IA : Em seguida, o A IA gera rascunhos, análises ou conteúdo com base nas indicações dadas. Esta é a fase da aceleração produtiva. A máquina propõe texto, identifica padrões ou mesmo sugere referências, seguindo sempre as orientações humanas iniciais. A contribuição da IA pode ser inestimável para ganhar velocidade e explorar abordagens, mas é fundamental assumir que O que é produzido nesta seção é um rascunho suscetível a erros .

- 20% de validação final e revisão humana : Finalmente, a pessoa realiza um faz uma crítica exaustiva de toda a produção de IA . Este é o filtro de qualidade indispensável: todas as informações são verificadas, todas as citações e referências são verificadas, o tom e a consistência são corrigidos, e o resultado é comparado com a realidade e com os objetivos iniciais. Esta fase pode envolver a consulta de fontes originais, o ajuste de nuances que a IA não capta (por exemplo, considerações legais ou culturais) e a garantia de que o produto final cumprir padrões éticos e rigorosos Esperado. Só quando a revisão humana dá a sua aprovação é que o trabalho é considerado concluído.

Esta abordagem 20–60–20 equilibra o poder da IA com o julgamento humano , de forma estruturada. Na prática, significa que o trabalho Iniciar sempre e ainda Terminar sempre com a intervenção humana, deixando a IA embutida no meio como uma ferramenta de apoio, não como um agente autônomo. Já o aplicámos em diferentes contextos. Por exemplo, em um projeto recente de treinamento de negócios, combinamos role-play de crises corporativas com o modelo 20-60-20 (20% de contextualização criativa, 60% de geração com ChatGPT e 20% de validação humana), fazendo com que os participantes melhorassem significativamente a coerência de suas análises sem reduzir a demanda crítica. A essência da metodologia é transformar a IA de um oráculo opaco para transformá-la em um Copiloto intelectual sob supervisão humana. Isto promove competências de engenharia de prompt , julgamento ético e análise estratégica, porque obriga o utilizador a interagir ativamente com a ferramenta, formulando boas instruções e depois auditando os resultados.

Uso em consultoria, o modelo 20–60–20 fornece Rigor e rastreabilidade precisamente onde a IA sozinha vacila. Durante os 20% iniciais, a equipa humana pode Prevenir muitas alucinações fornecendo contexto e fontes específicas à IA (por exemplo, carregando documentos de referência verificados ou restringindo as consultas a áreas bem definidas). No meio dos 60%, a produtividade dispara: a IA torna possível gerar rapidamente seções de texto, resumos ou gráficos de comparação, libertando os consultores do trabalho mecânico e permitindo-lhes iterar várias ideias em um curto espaço de tempo. Estudos recentes indicam que a IA generativa bem utilizada pode aumentar a produtividade do trabalho de conhecimento em cerca de 14%, em média , com melhorias especialmente notáveis em profissionais menos experientes. Esse impulso para a eficiência é real – a Deloitte procurava-o, sem dúvida – mas Só se materializa de forma segura se for acompanhada de disciplina na verificação dos resultados . É aí que entram os últimos 20%.

A fase crítica final garante que nada gerado pela IA chegue ao cliente sem antes passar pelo crivo da inteligência humana. Cada figura, cada citação bibliográfica ou legal será contrastada com fontes fiáveis; Qualquer declaração deve ser apoiada ou qualificada, conforme apropriado. Este é um antídoto direto para a falta de rastreabilidade e referências inventadas : Se a IA sugeriu um dado sem uma fonte, o consultor irá detetá-lo e substituí-lo por um dado verificado ou eliminá-lo completamente. Neste modelo, Nenhuma frase dúbia sobrevive à revisão final . A rastreabilidade é assegurada porque o resultado final é acompanhado por um Rastreio a partir de fontes reais que a própria equipa humana validou. Da mesma forma, a documentação do processo é enfatizada: salve o Prompts versões usadas, intermediárias e decisões de edição humana, para que, no caso de quaisquer dúvidas do cliente ou auditorias futuras, isso possa ser demonstrado o que a IA fez e o que o humano corrigiu – exatamente o tipo de registo que faltava no processo Deloitte.

20–60–20 incentiva um Cultura de colaboração humano-IA saudável . Não se trata de rivalidade ou substituição, mas de adicionar capacidades. Como resultado, o profissional desenvolve uma nova competência: ele sabe até onde confiar na máquina e onde iniciar o processo. Dúvida razoável . Nos nossos projetos temos visto jovens consultores que, seguindo este modelo, aprendem rapidamente a não Copiar-colar Não só as respostas do chatbot, mas sim usá-las como base para enriquecer ou corrigir com critérios. A IA deixa de ser uma caixa negra todo-poderosa e torna-se uma Assistente Estruturado , sempre sob o controle do perito humano.

O critério sênior: os 20% finais que a IA não pode substituir

Um aspeto fundamental do modelo 20–60–20 – e, diríamos, de qualquer estratégia sensata de adoção de IA – é o O papel insubstituível do julgamento humano sênior na última etapa do processo . A experiência do caso Deloitte é clara: se um profissional com um domínio profundo do assunto (por exemplo, um advogado sénior especializado em direito administrativo e constitucional) tivesse intervindo com rigor suficiente na fase final da revisão, é muito possível que tais erros flagrantes não tivessem passado despercebidos. Alguém com a seringa cheiro e o conhecimento acumulado que a antiguidade dá teria imediatamente questionado citações incomuns ou referências desconhecidas, da mesma forma que o Dr. Rudge fez ao analisar o relatório – com a diferença de que Rudge chegou ao Quando o estrago já estava feito , não antes.

O Última milha A IA não pode fazer isso por nós. Na consultoria de alto nível, como na auditoria, na medicina ou no direito, o julgamento pericial continua a ser a rede de segurança. Por mais avançado que seja o modelo generativo, falta-lhe uma compreensão contextual completa: não conhece as letras miúdas das leis, nem as implicações políticas de uma determinada recomendação, nem os valores organizacionais que matizam uma estratégia. Um sócio-consultor ou gestor de projeto experiente tem isso Sentido contextual e ético , e deve aplicá-lo conscienciosamente nos 20% finais. É a diferença entre um documento que é simplesmente Bem escrito e um documento correto e pertinente . Em sua essência, a IA generativa equivale a um analista júnior ou estagiário muito diligente: produz muito e muito rapidamente, mas Requer supervisão . Após o incidente australiano, as empresas devem treinar os funcionários não apenas no uso efetivo da IA, mas também em seu uso ético e na manutenção do controle de qualidade, tratando os resultados da IA como se tivessem sido preparados por um estagiário ou novo funcionário. O que sai do ChatGPT deve enfrentar o critério de sénior Assim como o relatório preliminar de um consultor iniciante passa pelos ajustes e correções do gestor ou sócio responsável.

Na nossa experiência, o contributo de profissionais seniores na revisão final acrescenta valor em três dimensões fundamentais:

- Qualidade técnica : Eles detetam inconsistências, erros conceituais ou omissões importantes que a IA (ou um humano inexperiente) não perceberia. No caso Deloitte, um perito jurídico sênior teria alertado que o caso Amato vs Commonwealth não tinha um veredicto publicável e que citá-lo como suporte jurídico era inadmissível. Da mesma forma, um alto funcionário de políticas públicas teria questionado afirmações sem um sólido suporte empírico.

- Ética e reputação : Um gestor com critérios éticos e valores de visão corporativa não só o que diz o relatório, mas como diz-o e que implicações tem. Por exemplo, ele poderia detetar preconceitos na linguagem gerada por IA, garantir que as recomendações não violem os princípios de equidade ou simplesmente decidir Não, não podemos entregar isso ao cliente se algo parece duvidoso. Em última análise, este filtro protege a relação com o cliente e a reputação da empresa.

- Adaptação contextual : A antiguidade envolve a compreensão do ambiente do cliente e das circunstâncias do projeto. Na fase final, o especialista dá o tom, prioriza as descobertas que são realmente relevantes para aquele cliente e contextualiza as recomendações. A IA pode produzir texto padrão, mas o ser humano sênior o transforma em uma mensagem estratégica sob medida.

Deve notar-se que a intervenção humana sénior não é um luxo, é um Obrigação profissional . Os códigos de boas práticas dizem isso porque a responsabilidade continua a recair sobre o profissional que utiliza IA, ou seja, delegar à máquina não isenta de culpa se algo correr mal. Os consultores devem: Apropriar-se do trabalho, verificar os resultados e aplicar seu julgamento em vez de copiar e colar o que o sistema produz . O relatório é assinado pela empresa de consultoria, não pelo algoritmo; Portanto, um parceiro deve ser capaz de defender cada parágrafo na frente do cliente. Se houver erros, eles são o nosso Erros. O objetivo não é evitar erros de IA, é garantir que somos inteligentes o suficiente para identificá-los como tomadores de decisão finais. É aqui que a experiência e o julgamento humano demonstram o seu valor: em reconhecer o que a IA pode ter feito de errado e corrigi-lo antes que transcenda .

Longe de tornar os profissionais obsoletos, a irrupção da IA tem Elevou a fasquia da antiguidade . Agora é quando mais precisamos de líderes com bom senso, capazes de integrar tecnologia de ponta em suas equipes sem sacrificar o controlo crítico . A IA pode cuidar da primeira camada de trabalho, mas a camada final de qualidade e senso estratégico ainda é território humano. É o melhor momento para bons estrategistas.

Transferir conhecimento, não apenas tecnologia

Outra lição estratégica deste caso é que A transferência de tecnologia sem transferência paralela de conhecimentos é irresponsável e insustentável . Estamos vivendo um boom de ferramentas de IA entrando nas organizações, mas comprar ou implementar a plataforma mais recente não é suficiente: você tem que se certificar de que as pessoas saibam como usá-la criteriosamente. Na Deloitte Australia, por exemplo, o GPT-4 foi usado através do Azure OpenAI – uma tecnologia de ponta – mas vale a pena perguntar se a equipa de consultoria foi devidamente treinada para o utilizar. Compreenderam as suas limitações, souberam verificar as suas respostas, tinham orientações claras para a sua utilização? A julgar pelo resultado (e pela necessidade de remendar o relatório pedindo novas referências à própria IA), é claro que Falta de formação interna no manuseamento responsável da ferramenta.

Essa lacuna entre tecnologia e conhecimento pode ocorrer tanto dentro de empresas de consultoria quanto entre consultores e clientes. Se uma empresa de consultoria entrega trabalho apoiado por IA sem divulgá-lo, ela não oferece ao cliente a oportunidade de aprender sobre o processo ou se preparar para dar continuidade a essa metodologia. Por outro lado, quando uma organização adota uma solução de IA por recomendação de terceiros, mas não dá formação aos seus trabalhadores Na nova dinâmica, você está comprando um bilhete para problemas futuros. Os clientes devem dominar as ferramentas que adotam , ou pelo menos compreender os seus riscos, caso contrário ficarão cegamente dependentes do fornecedor terceiro. É por isso que em cada projeto Proportione enfatizamos não só a implementação da solução técnica, mas também o acompanhamento com trabalho em grupo, manuais de melhores práticas e períodos de testes supervisionados. Introduzir a IA em uma organização envolve Gestão da Mudança : novos fluxos de trabalho, novas competências a desenvolver e uma cultura de controlo de qualidade.

No caso em questão, na esteira do escândalo, o governo australiano atualizou seus contratos para exigir que os consultores não apenas avisem com antecedência se usassem IA, mas também que preservar registros detalhados de interações com IA (prompts e resultados) e garantir que os dados da agência não sejam expostos indevida ou internacionalmente. Trata-se de medidas destinadas a assegurar que a O conhecimento do processo permanece acessível ao cliente . Se o DEWR tivesse recebido desde o início, juntamente com o relatório, um anexo com todas as mensagens enviadas ao modelo e as fontes sugeridas, os seus próprios analistas poderiam ter detetado inconsistências. Essa transparência forçada no uso da IA é uma forma de transferir know-how: o cliente pode auditar e, portanto, aprender onde a IA se encaixa (e onde falha) na tarefa em questão.

Voltando ao campo das empresas profissionais, a palavra de ordem deve ser Treine antes de automatizar . Isso vai desde treinar a equipe sobre fundamentos de IA (o que é um modelo de linguagem, o que ele pode e não pode fazer) até treiná-los em habilidades práticas: como escrever bons prompts para IA, como verificar respostas com fontes independentes, como identificar uma alucinação potencial, como evitar preconceitos, etc. Já existem projetos para melhorar a Literacia de Dados e IA das suas forças de trabalho, da mesma forma que há alguns anos se promoveu a formação em competências digitais gerais. Incorporar IA sem este reforço de formação é irresponsável. Não só a qualidade do produto está em risco, mas também a confiança dos funcionários na ferramenta. Se os profissionais sentirem que a IA é uma caixa preta que pode fazê-los parecer ruins, ou que a gestão a implementa sem lhes dar orientação, surgirão resistências compreensíveis ou, pior, usos indevidos. Por outro lado, ao adotar com pedagogia, a equipe entende que a IA é um aliado estratégico sob seu controle , e utiliza-o de forma mais eficaz e ética.

Cada euro investido em formação e clarificação de processos de IA compensará na prevenção de erros e na melhoria da produtividade. A tecnologia, por mais brilhante que seja, não garante resultados se as pessoas não souberem pilotá-la. Nesse sentido, Transferência de conhecimentos (metodologias, critérios, experiências) é ainda mais importante do que transferir a versão mais recente do software. O equilíbrio ideal é inseparável: Tecnologia + Conhecimento , ou não existe uma verdadeira transformação digital.

Conclusão: na era da IA é tempo de colocar sentido e responsabilidade

O "caso Deloitte Austrália" não é um simples percalço local ou uma arma contra a consultoria; é, acima de tudo, um sintoma e uma aprendizagem para todas as organizações imersas na corrida da IA. Recorda-nos que a incorporação de IA generativa no nosso trabalho traz enormes oportunidades, mas também riscos que têm de ser ativamente geridos. Podemos – e devemos – tirar uma conclusão desta história: não basta implantar a IA, é preciso formar critérios para usá-la de forma significativa .

O modelo 20–60–20 da Proportione de colaboração Humano–IA–Humano é uma das maneiras concretas de alcançar esse equilíbrio. Ele garante que o Criatividade aumentada por IA não é em detrimento do rigor ou ética , mas muito pelo contrário: aumenta a produtividade ao mesmo tempo que reforça o controlo humano em pontos críticos. Em última análise, métodos como este transformam o que poderia ser um salto para um vácuo tecnológico em um Salto controlado e estratégico . A IA está integrada, sim, mas sem deixar de lado o leme humano.

As organizações que aspiram a liderar na era da IA fariam bem em Adote salvaguardas proativas . Isto significa estabelecer protocolos internos claros, investir na formação contínua e fomentar uma cultura em que a antiguidade pesa mais do que nunca . Paradoxalmente, quanto mais avançadas forem as ferramentas, mais valiosa será a experiência humana e o julgamento para direcioná-las. Não se trata de abrandar a inovação, mas sim de Inove com sabedoria . Porque a questão já não é Sim utilizaremos a IA – que é um facto consumado – mas como Nós iremos. E nesse "como" é onde será definido quem alcança bons resultados sem comprometer a confiança.

Cada projeto, cada relatório, cada decisão assistida por IA deve ser concebida sob a premissa da dupla garantia técnica e humana. Vamos rever nossos processos hoje, adicionar que 20% de reflexão especializada no final e no início, e usar IA no meio 60% com os olhos bem abertos. Para quem lidera equipas, dê o exemplo aliando a curiosidade sobre a ferramenta à seriedade na supervisão. Para aqueles que estão começando a confiar no ChatGPT ou similar em seu trabalho diário, exija ainda mais na verificação do que é produzido. A IA pode acelerar o nosso ritmo, mas o caminho é marcado pelo julgamento humano . Na união de ambos está o futuro de uma consultoria eficiente e confiável – e, em geral, de uma gestão profissional.

Não basta adotar a IA: é preciso saber conduzi-la. A diferença entre uma catástrofe e uma história de sucesso dependerá, em grande medida, da manutenção desse equilíbrio inteligente entre a inovação tecnológica e a sabedoria humana. Está nas nossas mãos – não nas da máquina – garantir que a promessa da IA é cumprida sem trair a confiança que os clientes depositaram em nós.